La belleza espacial también puede ser mortal. |

Guerras extraterrestres

En la década de 1960, los EE.UU. lanzaron un cierto número de satélites sensores de rayos gamma (la serie Vela) a los efectos de monitorear el cumplimiento por parte de la URSS del recientemente firmado Tratado de Prohibición de Pruebas Nucleares. No se detectó ninguna explosión en la atmósfera terrestre, pero en cambio sí se descubrieron rayos gamma provenientes del espacio exterior. Parecía, como algún periódico sensacionalista publicó después, que algunos extraterrestres estaban ocupados en una masiva guerra interestelar.

De todos modos, como el descubrimiento sí era secreto militar, recién en 1973 la comunidad científica mundial tuvo noticia de estas misteriosas explosiones cósmicas. Pero en esa época todavía no había forma de determinar si esos estallidos se producían en nuestro sistema solar, o en algún otro lugar de la Vía Láctea, o incluso más lejos todavía.

Las propuestas de los investigadores sobre la naturaleza del fenómeno fueron muchísimas, pero hubo que esperar a que se desarrollaran nuevos instrumentos para aclarar la cuestión. Primero, y gracias al Observatorio Espacial Compton de la NASA (puesto en órbita el 15 de abril de 1991), se descubrió que, en promedio, había dos o tres de estos estallidos de rayos gamma al día, y que parecían provenir de todas partes del cielo. Esto casi eliminó como posible lugar de origen a nuestra galaxia, ya que la amplísima mayoría de las estrellas se encuentra en un disco más o menos aplanado, lo que no concordaba con las fuentes observadas.

Sin embargo, la discusión continúo por largo tiempo, con un bando que sostenía que los estallidos (más conocidos por las siglas de su nombre en inglés: GRBs = Gamma Ray Bursts) eran eventos “locales”, como por ejemplo cometas que cayeran en estrellas de neutrones ubicadas en el halo galáctico, y otro que opinaba que eran el producto de la muerte de estrellas masivas (y del consiguiente nacimiento de agujeros negros) que ocurrían en las profundidades del cosmos.

El asunto no fue zanjado hasta que, con el lanzamiento en 1996 del satélite ítalo-alemán Beppo-SAX, el uso combinado de detectores de rayos-X y de rayos gamma demostró que los estallidos de rayos gamma se originaban en galaxias tremendamente lejanas. El más distante, hasta ahora, surgió a 12 800 millones de años-luz de distancia, cuando el universo era muy joven (apenas unos 800 o 900 millones de años de edad).

Las mayores explosiones cósmicas desde el Big Bang

Ahora bien, para que un fenómeno de este tipo pueda ser observable a tanta distancia, debe ser realmente tremendo. La energía liberada en uno de estos estallidos, que duran desde un poco menos de un segundo hasta algunos minutos, equivale a la producida por nuestro Sol a lo largo de toda su vida de diez mil millones de años. De hecho, durante su brevísima existencia rivalizan con la luminosidad de todo el universo. .

Por supuesto, estas explosiones descomunales afectan una gran porción del espacio que las rodea. Se ha podido comprobar que, al menos en un caso, sus efectos nocivos se extendieron por más de 5 500 años-luz (un quinto de la distancia que nos separa del centro de nuestra galaxia). La materia que se encuentre dentro de su radio mortal será ionizada, y la vida que pudiera existir allí será eliminada. Por ejemplo, algunos investigadores creen que la extinción masiva Ordovícico-Silúrica que aconteció en nuestro planeta hace unos 450 millones de años y que extinguió a un 70% de todas las especies existentes en esa época, se debió a un estallido de rayos gamma demasiado cercano.

Pero, ¿cuál podría ser la causa de semejantes explosiones? Aunque no todos los detalles están claros, el evento se origina durante el nacimiento de un agujero negro, pero ocurre a menudo las cosas no son sencillas, y siempre encontramos complicaciones en los diferentes escenarios.

Para descubrir los secretos de estos estallidos, nuestros instrumentos no solamente examinan el estallido, sino también (lo que ha resultado ser más importante) el así llamado “post-resplandor”, una emisión en otros longitudes de onda (típicamente rayos-X, pero también en las visibles, por ejemplo) que dura mucho más tiempo (hasta varios meses, en algunas oportunidades) y que proporciona una información valiosísima.

El post-resplandor, emitido cuando la onda de choque de un GRB embiste al medio difuso que lo rodea, puede durar semanas o meses, para luego desaparecer progresivamente.

Los diferentes “sabores” de los GRBs

Uno de los primeros descubrimientos sobre los GRBs fue que se presentaban dos tipos de ellos, los “cortos” (que duran desde algunos milisegundos hasta aproximadamente unos dos segundos) y los “largos” (en general, de más de dos segundos y hasta algunos cientos de segundos de duración).

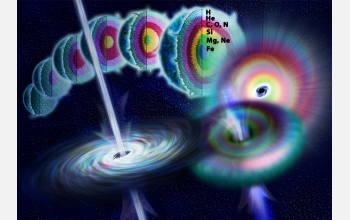

Los más numerosos entre los detectados hasta ahora son los “largos”, y parecerían ser la emisión colimada (es decir, con dos haces en forma de cono de partículas y fotones que surgen de los polos) producida por el colapso del núcleo de una estrella masiva que se convierte en un agujero negro.

GRBs de larga duración Según el modelo colapsar, los GRBs de larga duración se producen cuando una estrella masiva se convierte en agujero negro. © |

Según este modelo, cuando una estrella muy masiva llega al final de su vida, su núcleo colapsa súbitamente para formar un agujero negro, y la liberación de energía resultante destroza a la estrella.

Estas explosiones son bastante comunes, y los científicos las llaman “supernovas”. Pero a diferencia de la mayoría de ellas, que tienden a producir ondas esféricas de explosión, algunas tienen un comportamiento algo diferente. Los investigadores creen que eso puede ser el resultado de que una parte del gas del núcleo no pudo caer hacia el agujero negro por la velocidad de rotación del mismo. Entonces, esos gases forman un “disco de acreción” que rodea al agujero negro como un anillo.

Solamente el gas que se encuentra en el interior del anillo puede caer en espiral hacia el agujero negro, y cuando lo hace, libera enormes cantidades de energía que no tienen lugar adonde escapar, excepto a lo largo del eje del disco. Así se forman dos chorros opuestos que surgen de los polos del agujero negro: los GRBs de larga duración.

GRBs cortos Dos objetos muy compactos (estrellas de neutrones o agujeros negros) se fusionan para formar un agujero negro. Como resultado, se emiten dos haces que surgen de los polos: un GRB de corta duración. © |

Por otro lado, los “cortos” serían generados por la fusión de objetos estelares muy compactos (estrellas de neutrones o agujeros negros )que orbitan una alrededor de la otra (imagen superior).

En este modelo, el proceso comienza con dos estrellas muy masivas que componen un sistema binario; en unos 100 millones de años, ambos objetos llegan al final de sus vidas como estrellas y se convierten en estrellas de neutrones (o, incluso, una de ellas puede convertirse en agujero negro). En otros 100 millones de años, ambos objetos van perdiendo energía y se aproximan uno al otro recorriendo órbitas en espiral. Finalmente, entran en colisión y se fusionan, formando un agujero negro. Parte de la energía del estallido es emitida en forma de rayos gamma, un GRB de corta duración.

De todos modos, si bien ambos modelos predicen bastante bien las características de la mayoría de los GRBs, quedan todavía muchos detalles sin resolver, y se han propuesto otros mecanismos para explicarlos.

¿Una destructora de mundos?

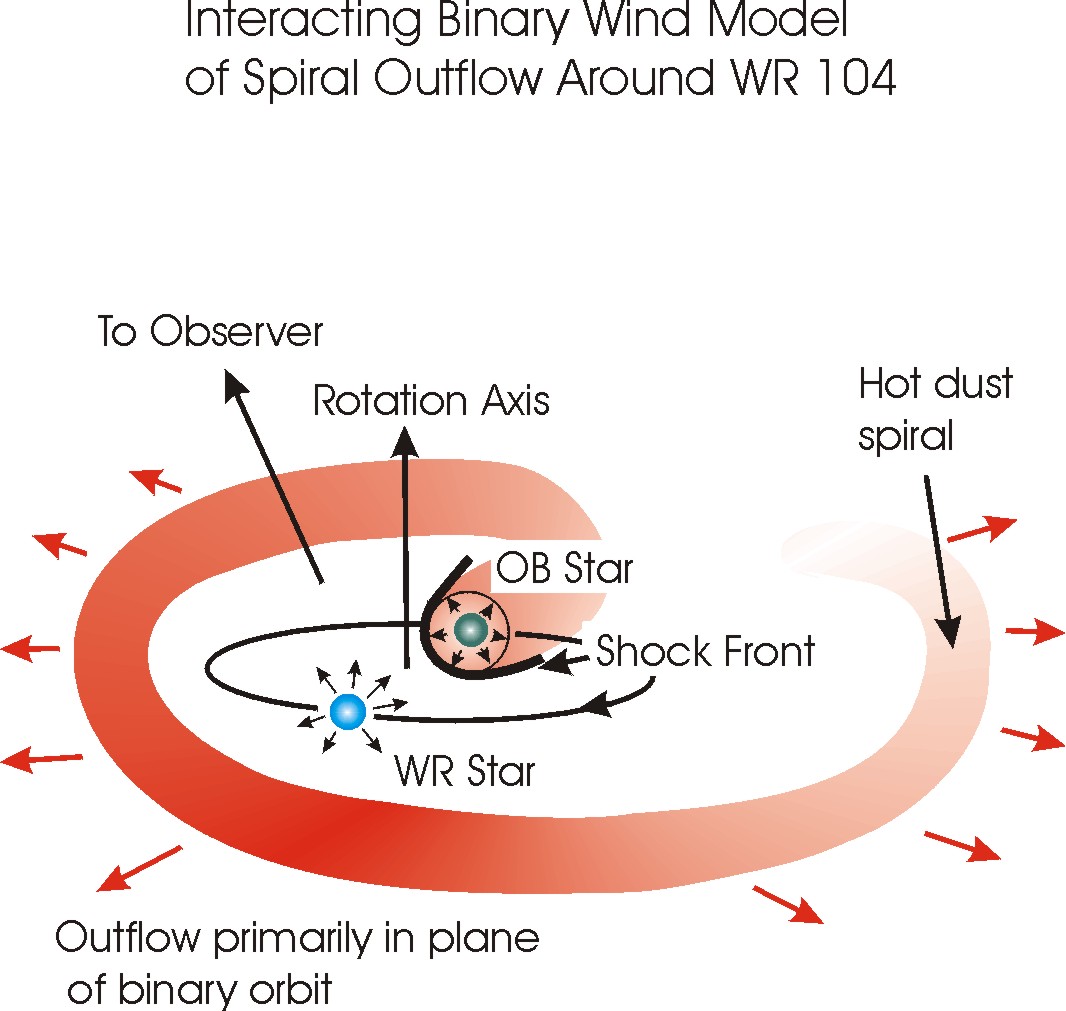

En 1998, el Dr. Peter Tuthill de la Universidad de Sydney descubrió una estrella rodeada por una hermosa espiral. Este objeto, conocido como WR 104, se encuentra en la constelación del Sagitario, a unos 8 000 años-luz de nosotros.

El nombre proviene de los apellidos de los descubridores de las estrellas de este tipo; las estrellas Wolf-Rayet tienen típicamente una masa veinte veces mayor que la de nuestro Sol, y pueden llegar a ser cien mil veces más luminosas. Son estrellas altamente evolucionadas a partir de progenitores gigantes tipo O (con una masa de hasta 80 Ms) que han perdido buena parte de su masa quedando casi únicamente su núcleo desnudo, y que se encuentran muy cercanas a convertir en supernovas.

La imagen de la espiral era hermosa, aunque presentaba un problema. Estaba compuesta por polvo, por lo que emitía radiación infrarroja. Pero si bien la estrella Wolf-Rayet tenía todos los elementos químicos como para producir polvo, la intensísima radiación de la estrella debía incinerarlo apenas al nacer.

Allí debía haber algo más, y en efecto lo hay. Una estrella tipo OB, bastante grande por sí misma pero que no resulta tan peligrosa como WR 104. El material expulsado por los vientos estelares de la estrella OB se encuentra en un frente de choque con los vientos estelares de la Wolf-Rayet., y en ese punto, bastante lejos de WR 104, el material es comprimido y como la temperatura es relativamente baja, el polvo se puede formar.

Ahora bien, por un lado, WR 104 es como una bomba de tiempo, y su reloj la hará detonar en cualquier momento dentro de un lapso de unos cientos de miles de años. Una supernova que ocurriera a esa distancia sería un hermoso espectáculo lleno de fuego de artificios, pero no nos causaría demasiado daño… si la estrella estuviera sola.

El problema con las estrellas de rotación muy rápida es que sus explosiones son probablemente bastante diferentes de la simple onda de choque esférica de sus primas de rotación lenta. Los astrónomos creen que las explosiones supernova de las primeras exhiben un eje preferencial alineado con el eje de rotación de la estrella en cuestión. Cuál es el grado de asimetría y cuánta energía y materia es arrojada en un haz a lo largo del eje, es algo que los científicos todavía están tratando de descifrar.

Pero lo que sí se sabe es que toda esa energía canalizada en un cono de unos 2 a 12 grados de apertura (un estallido de rayos gamma) puede sembrar la destrucción a lo largo de un trayecto considerablemente grande en su recorrido por la galaxia.

La amenaza WR 104

Y eso nos trae a los últimos datos obtenidos con observaciones realizadas con el telescopio Keck. La espiral luce hermosa porque la vemos sobre un plano perpendicular a nuestro punto de vista, es decir que esta ventajosa posición nos pone directamente sobre el eje de rotación de una de las más cercanas candidatas a supernova que conocemos Si hay un eje preferencial en esa explosión, podemos estar en el camino de un abrasador estallido de rayos gamma.

De todos modos, los datos no nos permiten conocer con exactitud si estamos en la orientación precisa. Además, hay muchísima incertidumbre sobre las características de la explosión supernova que sufrirá WR 104. Por si fuera poco, también se desconoce el grado de apertura que podría tener un haz GRB en este caso. Y tampoco tenemos una fecha más o menos precisa para el evento supernova.

Como dice Phil Plait en su blog Bad Astronomy, “el número de variables es demasiado grande, y la confección de modelos es notoriamente difícil… y en definitiva, no sabemos cuándo explotará. No vale la pena perder el sueño con este asunto”.

Claro que… el Dr. Tuthill es uno de los que más sabe sobre WR 104, y como expresa en la página web de la Universidad de Sydney, “yo solía apreciar esta espiral precisamente por sus hermosas formas, pero ahora no puedo evitar la ligera sensación de que es algo asombrosamente parecido a mirar hacia el cañón de un rifle”.

|